Yapay zekâ ile ünlü taklidiyle milyonluk vurgunlar: Deepfake videolar nasıl anlaşılır?

Ankara24.com, T24 kaynağından alınan bilgilere dayanarak haber veriyor.

Yapay zekâ ile ünlü isimlerin ses ve görüntülerinin taklit edildiği dolandırıcılık vakaları artış gösteriyor. Uzmanlar, bu tür arama ve içeriklerde en güvenli adımın iletişimi sonlandırmak olduğunu vurguluyor.

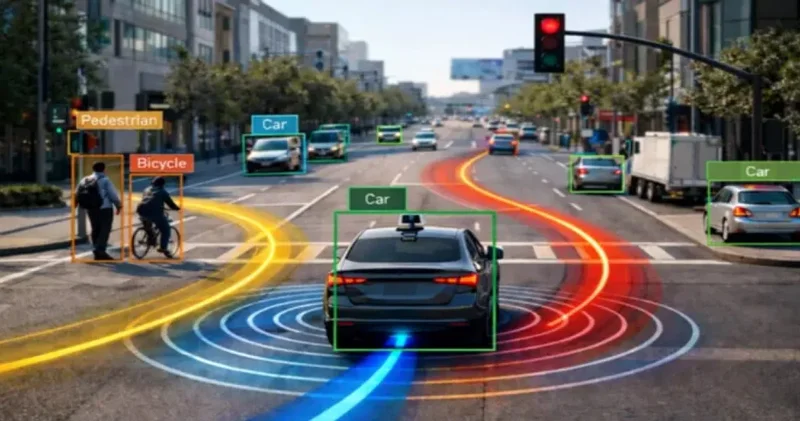

Yapay zekâ destekli dolandırıcılık yöntemlerinde son dönemde belirgin bir artış yaşanıyor. Ünlü isimlerin ses ve görüntülerinin taklit edilmesiyle oluşturulan sahte videolar, telefon aramaları ve yatırım reklamlarıyla çok sayıda kişi hedef alınıyor. Uzmanlar, yapay zekâ ile üretilen deepfake içeriklerin artık gerçeğinden ayırt edilmesinin zorlaştığını belirtirken, Türkiye’de de bu yöntemle hazırlanan sahte reklamlara inanarak parasını kaybedenlerin sayısının arttığına dikkat çekiyor. Sakarya’da 56 yaşındaki bir yurttaş, yapay zekâ ile üretilmiş Cumhurbaşkanı Recep Tayyip Erdoğan’ın görüntü ve sesinin kullanıldığı sahte reklamlar nedeniyle 2,5 milyon lira dolandırıldı.

Emniyet birimleri ve uzmanlar, benzer yöntemlerle gerçekleştirilen dolandırıcılık vakalarına yönelik operasyonların sürdüğünü bildiriyor. Düzce merkezli beş ilde düzenlenen bir operasyonda, yapay zekâ ile ünlü isimleri taklit ederek sahte yatırım reklamları hazırlayan şüphelilerin hesaplarında 25 milyon liralık işlem hareketi tespit edildi. Yurt dışında da benzer olaylar yaşanırken, Fransa’da bir mimar kadın, yapay zekâ ile üretilmiş görüntü ve mesajlarla Brad Pitt olduğunu zannettiği dolandırıcıya 800 bin euro gönderdi.

Sabah'tan Mevlüt Tezel'in göre, güvenlik uzmanı Perry Carpenter, teknik ayrıntılardan çok içeriklerin yol açtığı duygusal etkilere odaklanmak gerektiğini söylüyor. Korku, panik, aciliyet ya da otorite hissi uyandıran paylaşımlar onun için birer uyarı sinyali. Carpenter'a göre yapılabilecek en etkili şey, bu duygular devreye girdiğinde bilinçli biçimde yavaşlamak ve içeriği sorgulamak.

Uzmanlar deepfake videolardan bazıları göz kırpma gibi doğal akışta gerçekleşen davranışları başarıyla taklit etmekte zorlandığını belirtiyor. Gözlerin kırpılması esnasında meydana gelen düzensizlik, gözlerin duygusal ifadelerle uyumsuz olması, beklenmedik bir şekilde uzun süre açık kalan gözler gibi etkenler deepfake belirtileri olabilir.

Kişinin ses tonunda robotik, kendini tekrarlayan ifadelerden bir videonun sahte olduğunu tespit etme olasılığınız var. Ayrıca videolarda hareketler, kişilerin hareket tarzı ve ritmi tam anlamıyla uyum sağlamayabilir. Elbette sahte unsurları anlamak deepfake videosunun kalitesine bağlı.

Bu konudaki diğer haberler:

Bu konudaki diğer haberler: Görüntülenme:31

Görüntülenme:31 Bu haber kaynaktan arşivlenmiştir 29 Aralık 2025 10:22 kaynağından arşivlendi

Bu haber kaynaktan arşivlenmiştir 29 Aralık 2025 10:22 kaynağından arşivlendi

Giriş yap

Giriş yap

Haberler

Haberler Türkiye'de Hava durumu

Türkiye'de Hava durumu Türkiye'de Manyetik fırtınalar

Türkiye'de Manyetik fırtınalar Türkiye'de Namaz vakti

Türkiye'de Namaz vakti Türkiye'de Değerli metaller

Türkiye'de Değerli metaller Türkiye'de Döviz çevirici

Türkiye'de Döviz çevirici Türkiye'de Kredi hesaplayıcı

Türkiye'de Kredi hesaplayıcı Türkiye'de Kripto para

Türkiye'de Kripto para Türkiye'de Burçlar

Türkiye'de Burçlar Türkiye'de Soru - Cevap

Türkiye'de Soru - Cevap İnternet hızını test et

İnternet hızını test et Türkiye Radyosu

Türkiye Radyosu Türkiye televizyonu

Türkiye televizyonu Hakkımızda

Hakkımızda

En çok okunanlar

En çok okunanlar